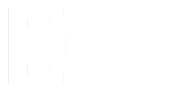

Скрін із відео нібито зустрічі президента РФ зі стюардесами. На відео видно прозорий мікрофон, через який проходить рука путіна

Український Центр стратегічних комунікацій повідомив про загрозу дезінформаційної кампанії діпфейків. Є версія, що окупанти планують змонтувати відео, на якому діпфейк президента Володимира Зеленського визнає капітуляцію України.

«Наші гроші. Львів» роз’яснюють, що таке діпфейки та як протидіяти згенерованим фальшивим відео.

Що таке діпфейк?

Діпфейк – це технологія штучно створених відео, які згенеровані за допомогою алгоритмів машинного навчання. У 2017 році користувач Reddit на ім’я Deepfakes почав застосовувати глибоке навчання для виготовлення підроблених відео зі знаменитостями. З цього почалась хвиля фейкових відео. Серед відомих прикладів, наприклад, відео, де Марк Цукенберг хвалиться, що має доступ до персонального життя мільярдів людей або Барак Обама пояснює, як працює ця технологія.

Щоправда, діпфейк створюють не лише для відео. Згенерувати можна і фото. Наприклад, у соцмережах створюють профайли з нереальними людьми, які нібито працюють у відомих організаціях або ЗМІ.

Як створюють діпфейк?

Концепція діпфейків дуже проста. Фактично, потрібно перенести обличчя однієї людини на відео з іншою.

Для цього потрібно зібрати датасет – сотні або тисячі годин відео з цією особою. Для обробки зображень найчастіше використовують GAN (Generative adversarial network) ‒ генеративно змагальну мережу. Фактично вона складається з двох нейромереж ‒ кодера і декодера. Кодер отримує реальні зображення «на вхід» та аналізує їх по кількох мільйонах параметрів (колір, форма, текстура, глибина). Далі параметри передаються іншій мережі ‒ декодеру, яка має відтворити зображення на основі вхідних даних.

Щоб уявити принцип роботи подумайте про складання фоторобота у поліції. Кодер ‒ це опис злочинця свідком (характерні риси), а декодер ‒ художник, який складає фоторобот.

Цикли постійно повторюються. З часом нейромережа може «домальовувати». Тобто «здогадатись», як має виглядати обличчя на згенерованому відео, навіть якщо саме такого зображення не було в оригінальному датасеті. Однак це доволі довгий процес і щоб отримати добрі результати потрібно кілька днів і щонайменше мільйони зображень. Якщо модель неправильно натренувати, то монтаж можна буде виявити. Наприклад, як у цьому моменті.

Ціль діпфейків

Діпфейки використовують для поширення паніки та щоб скомпрометувати особу. Особливо ефективно це тоді, коли часу на перевірку інформації обмаль. Адже спростування інформації працює набагато повільніше, ніж вірусне поширення.

Чи потрібен окупантам діпфейк Зеленського?

Технічний директор компанії Reface, яка працює із синтетичним відео, розповідав, що для запису промови з фальшивою капітуляцією навіть не потрібно змінювати обличчя президента. Адже це заняття потребує кількох днів роботи з нейромережею, яка покриє лише зону обличчя. Іншу частину відео доведеться монтувати і вписати кожен кадр.

Тому провокаторам достатньо накласти голос за допомогою технології ліпсинк (Lip Sync). Це тип нейромереж, які дозволять актору дубляжу записати будь-який текст максимально близьким до вашого голосу та синхронізувати з реальним відео. Виглядатиме так, ніби саме ви сказали ці слова.

Нещодавно, ліпсинк розмови путіна та міністра оборони РФ поширили у мережі. У фальшивій розмові говорять про війну в Україні, а міністр скаржиться на «сопратівлєніє».

Як відрізнити фейк від справжнього відео

Усе залежить від якості створеного відео і вашої уважності. При нормальній швидкості відтворення більшість людей «на око» не встигають нічого помітити. Якщо вивантажити усі реальні відео та порівняти його з діпфейком, то рухи збігатимуться майже на 100%. Щоправда, у спеціалістів є інструменти, які допомагають виявити фейкові відео.

Разом із тим, щоб протидіяти діпфейкам для початку можна скористатись загальними правилами протидії дезінформації:

- Побачили щось скандальне ‒ не поширюйте! Адже саме це і є мета усіх фейків.

- Подумайте про контекст. Чи не є щось нелогічним у інформації на відео? Якщо це тотальна «зрада» або «перемога» – це ще один привід додатково перевірити. Також у фейках часто немає посилання на авторитетне джерело.

- Перевірте інформацію у пошуку. Якщо інформація резонансна і про це не писали достовірні джерела – швидше за все, це ‒ фейк.

- Перегляньте повторно.

Якщо маєте підозру, ось вам кілька порад щодо характерних ознак згенерованих фото/відео.

Подивіться відео в уповільненому режимі або покадрово. Спробуйте відповісти на такі запитання:

- Чи не надто розмитий фон в порівнянні з іншими (нелицевими) ділянками відео?

- Чи є бліки, дефекти відео?

- Чи змінюється колір шкіри біля краю обличчя?

- Коли обличчя або руки частково закриті іншими предметами, воно зміщується чи розпливається?

Характерні дефекти діпфейкових зображень:

- Неприроднє волосся (у незвичних місцях, в протилежному напрямку, інакша текстура або нереально рівне)

- Несиметричні аксесуари (сережки, окуляри)

- Надто розмитий або нереальний фон

- Якщо людина посміхається, зуби не мають правильної форми, аморфні

- Неприродні згини одягу

- Дивна міміка та вираз обличчя, який не синхронізується з мовою та сенсом слів.

Матеріал підготовлено за підтримки New Democracy Fund. Матеріал відображає позицію редакції і не обов’язково відображає позицію New Democracy Fund.